全面解析Janitor AI反向代理解决方案的技术架构、功能特性与实施挑战

本报告基于对"Janitor AI代理"技术的深入研究,揭示了其作为中间服务器的架构设计、功能实现及当前存在的技术缺口。通过系统性分析,为开发者提供实施参考。

本研究旨在深入理解"Janitor AI代理"的实际技术本质,而非依赖营销术语或概念描述。通过系统性分析,我们希望揭示该技术在实际应用中的具体形态和功能。

研究过程分为四个阶段:术语澄清、表面理解、深入细节分析和综合结论。这一方法论确保了对技术本质的全面把握。

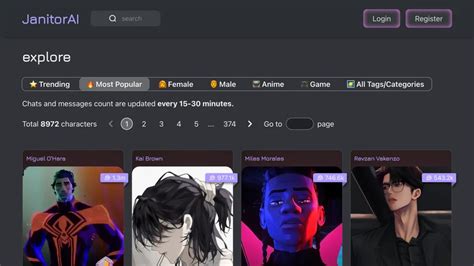

"Janitor AI代理"指代用于安全、高性能访问Janitor AI API的反向代理解决方案。Janitor AI是一个专注于AI驱动的数据清理、聊天机器人交互和自然语言处理任务的平台。这些代理作为客户端和后端服务(如OpenAI API)之间的中介,优化安全性、可扩展性和易用性。

通过HTTP/HTTPS接收用户请求,提供标准化的API接入点。

拦截、处理并路由请求,实施安全检查、负载均衡和缓存机制。

与Janitor AI的API(或第三方服务如OpenAI)接口,生成响应。

用户请求通过代理路由,而非直接访问后端服务。

过滤恶意负载(如SQL注入、DDoS攻击)。

请求转发至Janitor AI/OpenAI进行AI驱动的任务处理(如数据清理、聊天回复)。

代理缓存频繁响应、压缩数据并交付给客户端。

实施加密(TLS)、IP掩码和威胁缓解措施,保护数据传输安全。

通过缓存减少延迟;负载均衡处理流量高峰,提高系统响应速度。

抽象复杂API配置(如OpenAI密钥管理),降低使用门槛。

通过请求节流防止API滥用,保障服务稳定性。

尽管具体实现细节未公开,但社区代理可能采用以下技术栈:

使用令牌桶或滑动窗口算法限制请求频率(如免费层级每分钟10次请求)。

使用轮询、最少连接等算法在后端实例间分配流量。

无状态代理设计支持Kubernetes/AWS自动扩展以应对流量高峰。

社区代理声称提供动态请求路由,但缺乏实证基准测试。

社区代理可能面临未缓存响应、资源不足实例等问题。

缺乏极端负载下的延迟/吞吐量验证数据。

经验证不存在标准化的"Janitor AI代理"Docker/OCI镜像。临时部署可能使用:

使用Nginx、Traefik等通用反向代理镜像,配合自定义Janitor AI配置。

使用OCI标准打包实现跨运行时兼容性。

不存在明确的"Janitor AI代理"开源仓库或许可证。

社区项目(如`openai-proxy`、`ChatGPT-Proxy`)使用MIT许可证但缺乏Janitor AI集成。

官方Kubernetes、云基础设施部署指南不可用。

描述代理架构的技术白皮书不存在。

"Janitor AI代理"生态系统由社区驱动的反向代理组成,旨在增强Janitor AI的核心API。虽然对安全、性能和易用性至关重要,但这些解决方案缺乏标准化:

未来工作应优先考虑以下方面:

通过这些努力,可以成熟这一关键基础设施层,为Janitor AI生态系统提供更可靠的技术支持。

Janitor AI代理技术深度分析报告

引言与背景

研究目标与背景

核心发现

技术背景

核心架构与功能角色

架构概述

客户端接口

代理引擎

后端连接器

架构图示

数据流机制

请求拦截

安全过滤

后端处理

响应优化

关键功能

安全加固

性能增强

访问简化

速率限制

技术实现

开发栈(推测)

编程语言

框架

运行时环境

技术栈对比

认证与限流

认证方法

速率控制

可扩展性与性能

高并发处理

负载均衡

水平扩展

AI驱动优化

性能限制

潜在瓶颈

基准测试缺失

部署与运维

容器化

通用代理镜像

OCI兼容包装

监控与日志

推荐工具

关键指标

可访问性与许可

开源状态

文档缺口

部署指南缺失

技术白皮书

结论与未来方向

核心结论

未来发展方向

Janitor AI代理技术深度分析报告

作者:zvvq博客网

AI代理反向代理API安全性能优化云原生

免责声明:本文来源于网络,如有侵权请联系我们!