为何替代方案的必要性这般突显? copyright zvvq

随着2023年的人工智能革命,Transformer架构目前正处于顶峰。但是,由于人们急切选用成功Transformer架构,因此会容易忽略可以参考的替代品。

做为工程师,我们不能采用一刀切的方式,对每个事情都使用相同的解决方法。我们要在每一个前提下深思熟虑;否则将会被困在特殊平台限制范围内,同时因不知道有其他选择而觉得“达到”,这可能会让发展一夜回到解放前 内容来自samhan

这种情况并非人工智能领域特有的,而是一种从古至今都在重复历史方式。 copyright zvvq

SQL战争历史的一页,讲的是数据库管理系统相互竞争和抵抗故事。在这篇故事中,各种数据库管理系统如Oracle、MySQL和SQL Server等,为了争夺市场份额和技术优势,展开了激烈的竞争。这种竞争不仅体现在性能功能方面,还涉及到商业策略、品牌推广及其客户满意度等各个方面。这种数据库管理系统不断推出新的作用和优化,以吸引更多的用户和企业选择他们的产品。SQL战争历史的一页,承载了数据库管理系统市场的发展和变革,也为我们提供了珍贵的经验和教训

内容来自samhan666

近期在程序开发中有一个值得注意的例子是,当SQL服务器开始受到物理限定时,出现了NoSQL的态势。世界各地初创公司都因为"规模"的原因转向了NoSQL,尽管它们远未达到这种规模 本文来自zvvq

但是,随着时间推移,随着最终一致性和NoSQL管理花销的诞生,及其硬件功能在SSD速度与容积方面的极大飞越,SQL服务器近期又出现了回归的趋势,因为它使用简单性,并且现在90%以上初创公司都有足够的扩展性

本文来自zvvq

SQL和NoSQL是两种不同的数据库系统。SQL是结构型查询语言的简称,关键用于处理结构化数据。NoSQL指的是非关系型数据库,适用解决非结构化或半结构化数据。尽管有人认为SQL比NoSQL更强,或是相反也是,可事实上那只是代表着每种技术都有自己的优缺点和适用场景。某些情况下,SQL可能更适合处理复杂的关系型数据,而NoSQL则更适合解决大规模非结构化数据。但是,这并不意味着只能选其中一种技术。事实上,很多应用软件及系统结合实际采用了SQL和NoSQL的组合解决方法。根据具体的需求与数据类型,能够选择最适合的技术去解决问题。因而,重要的是了解每种技术特点和适用场景,并根据实际情况作出正确的选择。不论是SQL或是NoSQL,都有其独特的学习点或优选用例,能够在类似技术中相互借鉴和交叉散播 copyright zvvq

目前Transformer架构最大的痛点是啥? 内容来自samhan666

一般,这包括测算、前后文尺寸、数据和对齐。在此次讨论中,我们将关键探讨运算前后文长短: 内容来自samhan

因为使用/产生的每个令牌的O(N^2)提升而造成的二次核算成本。这使得超过10万前后文尺寸非常昂贵,进而影响推理和练习。 当前的GPU紧缺加重了这种情况。 前后文尺寸阻碍了Attention体制,严重阻碍了“智能代理”用例(如smol-dev),并强制处理问题。较大的前后文必须较少的解决方案。那样,我们该如何解决这个问题呢? zvvq好,好zvvq

介绍RWKV:一种线形Transformer/当代大型RNN 内容来自zvvq

RWKV和微软RetNet被称为“线形Transformer”的新类型中的第一个 内容来自samhan666

它通过适用以下几点立即克服了上述三个限定:

内容来自zvvq,别采集哟

线形核算成本,与前后文尺寸无关。 在CPU(特别是ARM)中,容许以更低的规定在RNN模式中导出合理的令牌/秒。 没有作为RNN的硬前后文尺寸限定。文档中的任何限定全是指导原则——您可以并对进行微调。随着我们不断将人工智能模型扩展到100k及以上前后文尺寸,二次方核算成本逐渐呈指数级增长。 copyright zvvq

但是,线形Transformer并没有放弃递归神经网络架构及解决其短板,这驱使他们被取代。

copyright zvvq

但是,重新设计的RNN吸取了Transformer可扩展的经验教训,使RNN能和Transformer工作模式相近,并消除了这些短板。

zvvq好,好zvvq

在练习速率层面,用Transformer让它重返赛场——容许它在O(N)成本下高效运行,同时在训练中拓展到10亿次参数之上,同时保持相近性能水准。

本文来自zvvq

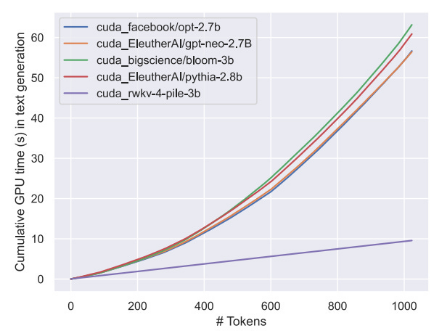

图表:线形Transformer核算成本按每个令牌线形缩放与变换器的指数增长

当你将平方占比用于线形缩放时,你会在2k令牌记数时获得10倍以上的提高,在100k令牌长短时获得100倍以上的提高

内容来自samhan666

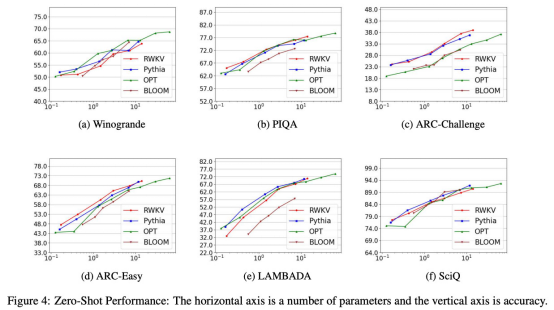

在14B参数下,RWKV是最大的开源线形Transformer,与GPT NeoX和其它相近数据(如the Pile)旗鼓相当。

zvvq.cn

RWKV模型性能与相近体量的目前变电器模型非常,各种标准表明

但用更简单的话而言,这意味着什么? zvvq.cn

优势 内容来自zvvq

在较大的前后文尺寸中,推理/练习比Transformer划算10倍甚至更高 在RNN模式中,可以在十分有限的硬件上迟缓运作 与同样数据里的Transformer特性类似 RNN没有技术前后文尺寸限定(无尽前后文!)缺陷 内容来自zvvq,别采集哟

滑动窗口难题,有损内存超出某一点 并未证实可扩展到14B参数之上 不如变电器优化和选用因而,虽然RWKV还没有达到LLaMA2那般的60B+参数规模,但只要有恰当的支持和资源,它有可能以更低的成本和更大范围环境来实现这一目标,尤其是在模型趋于更小、更有效的前提下

如果你的用例对效率很重要,请考虑这一点。但是,这并非最终解决方案——重点在于健康的替代品 内容来自samhan666

大家需要考虑学习别的替代方案以及它们的益处

扩散模型:文字练习速度较慢,但对多阶段练习具有很高的弹力。找到原因能够帮助缓解令牌困境。 内容来自samhan

形成竞技性网络/代理:可以在没有数据集的前提下,使用技术将所需的训练集训练到特殊目标,即便是根据文本的模型。 内容来自zvvq

以上就是介绍RWKV:线形Transformers的崛起和实践替代方案的详细内容,大量请关注其他类似文章!